Le CSAM d’Apple destiné à la sécurité de l’enfant va se développer dans tous les pays

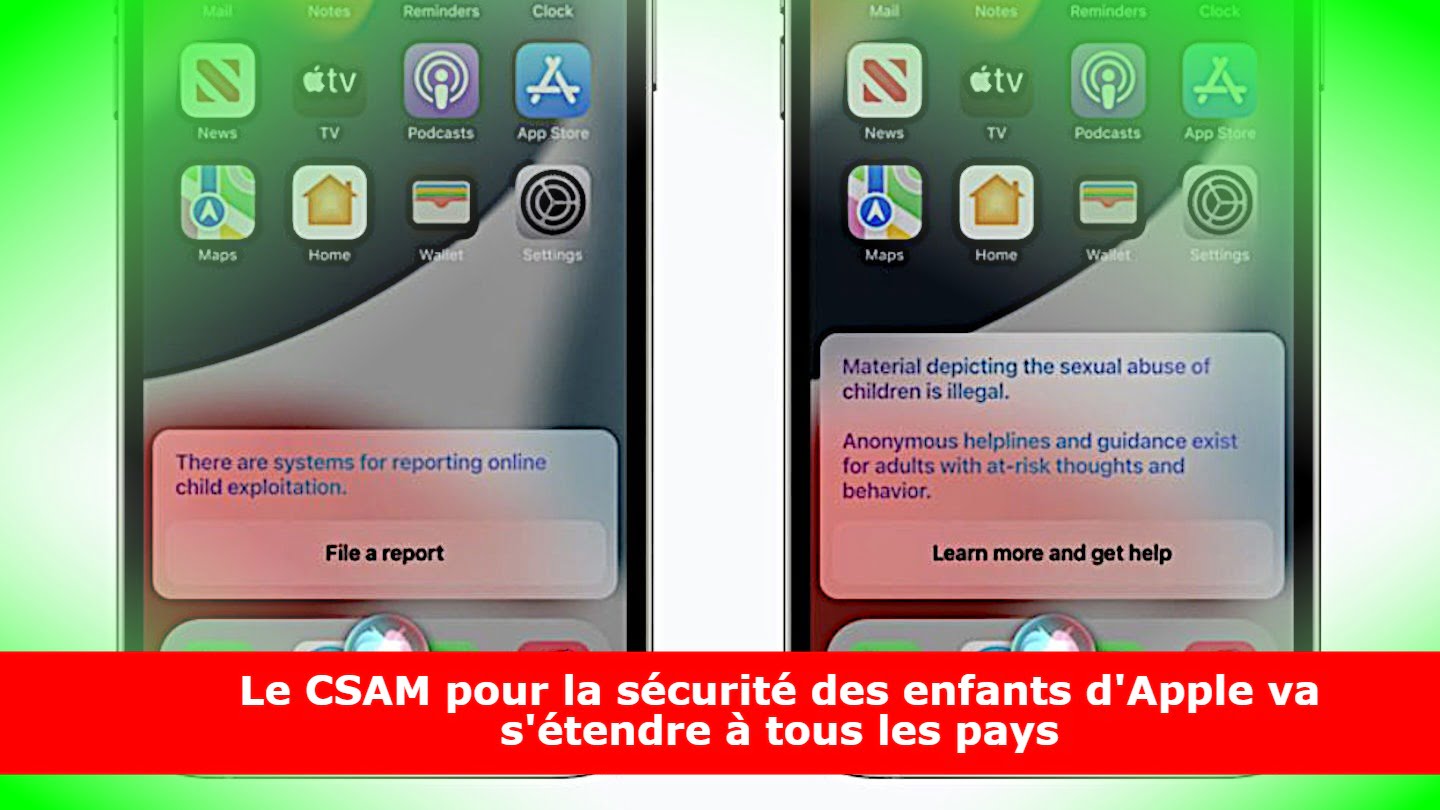

Apple, dont les efforts en matière de protection de la vie privée sont très appréciés, a dévoilé il y a quelques jours une nouvelle fonctionnalité destinée à protéger les enfants en signalant les contenus illégaux stockés sur le compte iCloud Photos d’un utilisateur.

Alors que les deux parties s’accordent à dire que les enfants devraient être protégés en réprimant la pornographie infantile ou le matériel CSAM, certains critiques affirment que ce système pourrait potentiellement être utilisé de manière abusive par d’autres gouvernements.

Aujourd’hui, Apple précise que ce ne sera pas le cas et qu’elle envisagera le déploiement de la détection de CSAM pays par pays.

Il n’est pas surprenant que les défenseurs de la vie privée aient qualifié la nouvelle fonction d’analyse CSAM d’Apple de logiciel espion ou de logiciel de surveillance en raison de la manière dont elle pourrait potentiellement violer la vie privée d’une personne, en dépit des assurances données par Apple.

La méthode de détection de la présence de contenu CSAM dans les photos est à l’origine de la controverse. Cette méthode fait appel à l’IA et à l’apprentissage automatique afin d’éviter que les humains n’aient à scanner manuellement les photos.

Bien que cette méthode constitue en soi une forme de protection de la vie privée, elle laisse également la porte ouverte aux abus et aux violations potentielles de la vie privée.

Les détracteurs de cette technologie font valoir que le système d’apprentissage automatique peut être alimenté par d’autres données, volontairement ou accidentellement, qui pourraient ensuite être utilisées pour détecter et signaler des contenus sans rapport avec le système CSAM.

Cette technologie pourrait, par exemple, servir de système de surveillance de masse pour les activistes dans les pays aux gouvernements plus répressifs.

Appelle a déjà indiqué son intention d’étendre sa détection CSAM aux iPhones et iPads du monde entier, alimentant la controverse.

Désormais, l’entreprise a précisé qu’elle ne procéderait pas à un déploiement général sans tenir compte des spécificités des lois de chaque marché.

Ceci pourrait rassurer les citoyens de Chine, en Russie et dans d’autres pays aux lois de censure strictes.

Le système de détection CSAM sera d’abord déployé aux États-Unis, où Apple est depuis longtemps un fervent allié de la protection de la vie privée.

Cela pourrait ne pas satisfaire les défenseurs de la vie privée, car ils considèrent que le système lui-même est ouvert aux abus.

Si Apple a dénoncé à plusieurs reprises la création de portes dérobées dans des systèmes de sécurité solides, il lui est aujourd’hui reproché de créer exactement cela, quelle que soit l’étroitesse ou la qualité de cette porte dérobée.